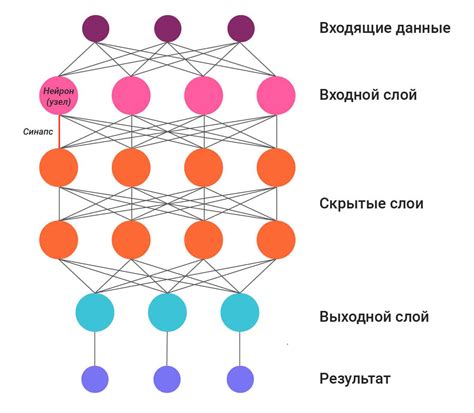

Новейшие технологии нейросетей позволяют сегодня решать самые сложные задачи и предсказывать прогнозы с поразительной точностью. Однако, как и любая технология, они подвержены определенным ограничениям. Одним из таких ограничений является переобучение - явление, когда нейросеть приспосабливается к исключительно тренировочным данным и теряет способность обобщать полученные знания в реальных ситуациях. Отсутствие способности к обобщению - это важный сигнал для исследователей и разработчиков, что модель достигла предела своей эффективности и нуждается в коррекции.

Определение переобучения нейросети - сложная задача, требующая глубокого анализа данных и применения различных методов. Один из таких методов - анализ коэффициента ошибки. Коэффициент ошибки позволяет сравнить результаты предсказаний нейросети на тренировочных данных и на новых данных, не участвовавших в процессе обучения. Если коэффициент ошибки существенно возрастает на новых данных, это может говорить о переобучении нейросети.

Другим методом проверки на переобучение является валидационный набор данных. После обучения нейросети на тренировочных данных, создается набор данных, который модель не видела ранее. Нейросеть производит предсказания на этом валидационном наборе данных, и если точность предсказаний существенно ниже, чем на тренировочных данных, возможно, модель переобучена и требуется дальнейшая настройка.

Оценка обобщающей способности нейросети при помощи кросс-валидации

В данном разделе рассматривается метод оценки эффективности работы нейросети, который позволяет оценить ее способность обобщать полученные знания на новые данные.

Кросс-валидация является одним из наиболее распространенных и надежных методов оценки обобщающей способности нейросети. Ее применение позволяет снизить риск переобучения, то есть ситуации, когда нейросеть хорошо справляется с обучающими данными, но плохо работает на новых.

Принцип кросс-валидации заключается в разделении имеющихся данных на фиксированное число непересекающихся подвыборок. Затем каждая из этих подвыборок последовательно используется в качестве тестового набора данных, а оставшиеся подвыборки – как обучающие. Таким образом, мы получаем несколько оценок качества работы нейросети на разных наборах данных, что позволяет получить более объективную оценку ее обобщающей способности.

Одним из наиболее распространенных типов кросс-валидации является "k-fold" кросс-валидация, где имеющиеся данные делятся на k подвыборок. Каждая из этих подвыборок последовательно выступает в роли тестового набора данных, а оставшиеся k-1 подвыборок – в роли обучающих. Качество работы нейросети на всех k итерациях усредняется для получения итоговой оценки.

Кросс-валидация является ценным инструментом при обучении и оценке нейросетей, позволяя более надежно определить ее способность работать с разнообразными данными и уменьшить риск переобучения.

Отслеживание уровня функции потерь

В данном разделе будет освещена тема, связанная с контролем функции потерь при использовании нейросетей. Речь пойдет о методах, которые позволяют оценить и управлять этим параметром, чтобы избежать переобучения модели.

Функция потерь является одним из ключевых показателей эффективности нейронных сетей. Она позволяет вычислить разницу между реальными и предсказанными значениями. Однако в процессе обучения модели может возникнуть опасность переобучения, когда функция потерь на тренировочных данных становится слишком низкой, но на тестовых данных результаты оказываются недостаточно точными.

В данном разделе будут представлены различные методы, которые помогут контролировать уровень функции потерь и предотвращать переобучение нейросети. Будут рассмотрены такие аспекты, как регуляризация, кросс-валидация, ранняя остановка и многие другие.

- Регуляризация - метод, который добавляет штрафные компоненты к функции потерь, чтобы предотвратить слишком высокую сложность модели.

- Кросс-валидация - техника, позволяющая оценить качество модели путем разделения данных на несколько подмножеств и проведения множественных обучений и тестирований.

- Ранняя остановка - стратегия, которая позволяет прекратить обучение модели, когда функция потерь на валидационной выборке перестает улучшаться.

Использование данных методов позволит более эффективно контролировать функцию потерь и предотвращать переобучение нейросети. Дальнейшая работа с моделью будет более надежной и результативной.

Использование регуляризации для предотвращения избыточного обучения

Регуляризация - это техника, которая помогает контролировать сложность модели, ограничивая значения ее параметров или добавляя штрафные члены к функции потерь. Она помогает снизить влияние случайных шумовых данных на обучение и улучшить обобщающую способность нейросети. Основная идея заключается в добавлении дополнительного члена к функции потерь, который штрафует большие значения параметров.

Существуют различные виды регуляризации, такие как L1 и L2-регуляризация. L1-регуляризация добавляет штрафной член, пропорциональный абсолютному значению параметра, что приводит к разреживанию модели и отбору признаков. L2-регуляризация, с другой стороны, добавляет штрафной член, пропорциональный квадрату значения параметра, что приводит к сжатию параметров и рассеянию весов. Оба вида регуляризации способствуют уменьшению переобучения путем управления сложностью модели и повышения ее обобщающей способности.

При использовании регуляризации важно найти правильный баланс между минимизацией функции потерь и штрафом за сложность модели. Это можно осуществить путем настройки коэффициента регуляризации, который контролирует вклад регуляризации в общую функцию потерь. Подбор правильного значения этого коэффициента является важным шагом в процессе предотвращения переобучения и обеспечения хорошей обобщающей способности нейросети.

Анализ градиентов и весов нейросети

В данном разделе мы рассмотрим подходы к анализу градиентов и весов нейронной сети, с целью выявления и предотвращения проблемы переобучения. Исследование изменений градиентов и весов при обучении позволяет получить информацию о процессе обучения и выявить потенциальные проблемы, связанные с переобучением.

Один из важных аспектов анализа градиентов и весов - это их распределение. Склонность градиентов или весов к слишком большим или слишком малым значениям может сигнализировать о проблемах в работе нейросети. Например, негативное распределение градиентов может указывать на наличие градиентного взрыва, когда значения градиентов слишком быстро увеличиваются и приводят к нестабильному обучению. А значительные отклонения весов нейросети от оптимальных значений могут свидетельствовать о появлении шума и неправильной настройке параметров сети.

Для анализа градиентов и весов нейросети можно использовать различные инструменты и методы, такие как гистограммы, среднеквадратичное отклонение, стандартные отклонения или визуализацию весов через тепловые карты. Детальное изучение градиентов и весов в разных слоях нейросети может помочь выявить причины переобучения и предложить возможные решения, такие как регуляризация модели или изменение гиперпараметров.

Важно отметить, что анализ градиентов и весов является только одним из инструментов оценки переобучения и не может решить проблему в изолированном виде. Но он может быть полезным дополнением к другим методам проверки нейросети на переобучение, таким как кросс-валидация, регуляризация или early stopping.

Вопрос-ответ

Какие методы можно использовать для проверки нейросети на переобучение?

Для проверки нейросети на переобучение можно использовать различные методы, такие как кросс-валидация, отложенная выборка и регуляризация.

Что такое кросс-валидация и как она помогает в проверке нейросети на переобучение?

Кросс-валидация - это метод, который помогает оценить работу нейросети на разных наборах данных. Он заключается в разделении данных на несколько подмножеств (например, на 5 фолдов), после чего модель обучается на одной части и тестируется на оставшихся. Таким образом, кросс-валидация позволяет оценить работу нейросети не только на одной выборке, но и на нескольких, что помогает выявить переобучение.