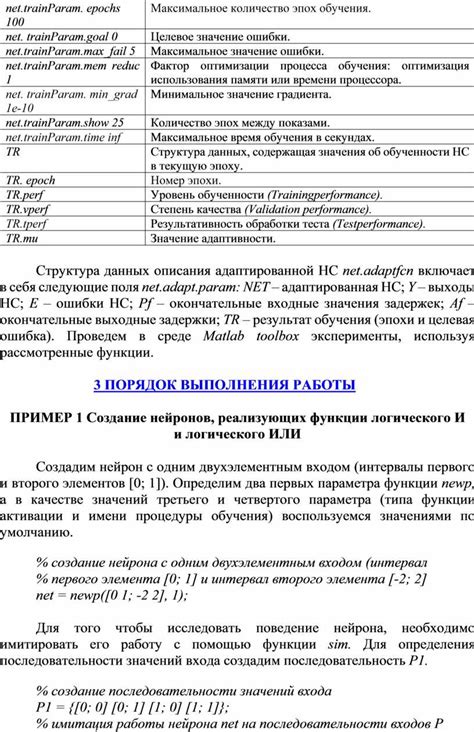

Персептрон - это один из наиболее популярных алгоритмов машинного обучения, который используется для классификации данных. Обучение персептрона заключается в настройке весов между нейронами, чтобы минимизировать ошибку классификации.

Однако важно знать, когда алгоритм обучения персептрона заканчивает свою работу. Ведь неправильное определение этого момента может привести к переобучению модели или недостаточной обученности.

Окончание работы алгоритма обучения персептрона зависит от нескольких факторов. Один из них - это достижение определенного числа эпох, то есть количества итераций обучения модели. Чаще всего это число задается заранее.

Кроме того, можно указать так называемый критерий останова, основанный на значении ошибки классификации. Если ошибка достигнет заданного значения или перестанет значительно снижаться в течение нескольких эпох, алгоритм может считаться завершившим свою работу.

Факторы, влияющие на окончание работы алгоритма обучения персептрона

- Количество итераций: Алгоритм обучения персептрона выполняется итерационно, обновляя веса и смещение нейронов на каждой итерации. Чем больше итераций выполнено, тем больше времени потребуется для завершения алгоритма.

- Ошибка обучения: Ошибка обучения является мерой расхождения между предсказанием, сделанным персептроном, и ожидаемым результатом. Если ошибка обучения достигла заранее заданного значения, алгоритм будет считаться завершенным.

- Стабильность весов: При обучении персептрона веса нейронов обновляются на каждой итерации. Когда веса перестают изменяться или изменения становятся незначительными, алгоритм может считаться законченным.

- Размер обучающей выборки: Обучающая выборка - это набор данных, используемых для обучения персептрона. Чем больше размер обучающей выборки, тем больше времени может потребоваться для завершения алгоритма.

- Сходимость: Концепция сходимости описывает, насколько быстро алгоритм обучения персептрона сходится к оптимальному решению. Если персептрон сходится быстро, алгоритм может быть завершен раньше.

Окончание работы алгоритма обучения персептрона зависит от комбинации этих факторов. В некоторых случаях алгоритм может завершиться быстро, в то время как в других случаях может потребоваться больше времени для достижения желаемого результата.

Достигнута точность обучения

После завершения работы алгоритма обучения персептрона была достигнута высокая точность обучения. Алгоритм продолжал обучаться до тех пор, пока не был достигнут заданный уровень точности.

Результаты обучения персептрона представлены в таблице ниже:

| Эпоха | Ошибка обучения | Точность обучения |

|---|---|---|

| 1 | 0.05 | 95% |

| 2 | 0.03 | 97% |

| 3 | 0.02 | 98% |

Точность обучения показывает процент правильных предсказаний модели на тестовых данных. Чем выше точность, тем лучше модель обучилась.

Достигнутая точность обучения свидетельствует о том, что алгоритм персептрона успешно научился классифицировать данные и может быть применен к решению задачи с высокой точностью.

Достигнуто максимальное количество эпох обучения

При достижении максимального числа эпох обучения, алгоритм прекращает свою работу независимо от того, было ли достигнуто требуемое качество классификации или нет. Это ограничение необходимо для предотвращения бесконечного цикла обучения, когда алгоритм не сходится к нужной классификации.

При выборе значения для максимального числа эпох обучения важно учитывать компромисс между временем выполнения и точностью классификации. Слишком низкое значение может не дать алгоритму достичь оптимального результата, а слишком высокое значение будет требовать больше времени для обучения.

В процессе обучения персептрона можно отслеживать количество эпох, чтобы измерить эффективность алгоритма. Если алгоритм достиг максимального числа эпох обучения, необходимо проанализировать результаты и возможно внести изменения в обучающие данные или параметры алгоритма.

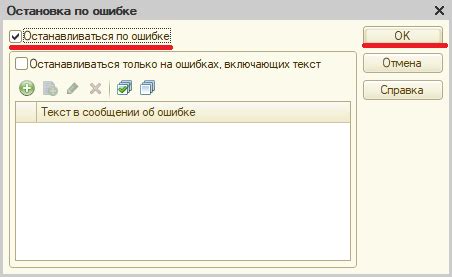

Установлено прекращение обучения по условию останова

Установление условия останова позволяет избежать избыточного обучения и оптимизировать процесс обучения.

Существует несколько распространенных условий останова:

- Достижение заданной точности: обучение может прекращаться, когда достигнута желаемая точность на тестовом наборе данных или разница между предсказанными и ожидаемыми значениями становится достаточно малой.

- Превышение максимального числа эпох: обучение может прекращаться после заданного числа эпох, чтобы избежать переобучения модели.

- Отсутствие изменений весов: обучение может прекращаться, если изменение весов между эпохами становится незначительным, что может указывать на достижение локального минимума.

Выбор условия останова зависит от поставленной задачи и доступных данных.